Fører opplæring i felles vurderingskriterier til større grad av enighet? En studie av tekstvurdering som en del av spesialpedagogutdanning

Denne studien viser at det er vanskelig å finne pålitelige vurderingsformer for elevtekster. Det er et stort behov for forskning som ser på hvordan pålitelighet for tekstvurdering kan økes og hvilke didaktiske tilnærminger som forbedrer vurderingsevnene blant studenter innen pedagogiske studier.

Hovedformålet med studien var å undersøke effekten av å gi spesialpedagogikkstudenter undervisning og trening i å bruke felles vurderingskriterier i møte med tekstvurdering. Studien tar utgangspunkt i datamaterialet fra NORM-prosjektet, der et utvalg elevtekster har blitt samlet i et digitalt korpus (Berge et al., 2017). Førti spesialpedagogikkstudenter vurderte de samme fire elevtekstene fra Normkorpuset, to før og to etter intervensjonen. Hensikten var blant annet å undersøke om studentene hadde større grad av enighet i sine vurderinger etter intervensjonen. Resultatene viste at det ikke var signifikante forskjeller i grad av enighet før og etter intervensjonen på de fleste områdene. Det kan være flere årsaker til dette. For eksempel er det mulig at intervensjonen var for kortvarig eller at skalaen som brukes for å måle de ulike vurderingsområdene var for lite nyansert for å fange opp små endringer i studentenes vurderingsferdigheter. Studiens funn understreker at det er svært vanskelig å finne pålitelige vurderingsformer for elevtekster, og øke påliteligheten blant studenter gjennom trening i vurderingsområder og skriveforventinger. Det er et klart behov for mer forskning på hvordan en kan øke pålitelighet for tekstvurdering og finne didaktiske tilnærminger for å forbedre vurderingsevner blant studenter innen pedagogiske studier.

The main goal of the study was to investigate whether teaching and training in a shared set of assessment criteria results in a greater degree of consistency in the assessment of writing performance. The study was based on data collected from the study “Developing national standards for writing. A tool for teaching and learning”, also known as the “the Norm project” (Berge et al., 2017). Forty preservice special educators rated the same 4 pupil-texts before and after an intervention consisting of lectures and seminars on writing norms and formal assessment criteria. The results showed no significant differences in agreement between students’ assessments before and after the intervention. There are several possible explanations for these findings. For example, the lack of change may be due to the limited scope of the intervention or connected to characteristics of the assessment tool. The findings also illustrate the difficulty associated with conducting reliable assessments of pupils’ writing and increasing the quality of preservice educators’ assessments through training. There is a clear need for more research on how to increase the reliability of writing assessment and find better approaches to improving the assessmentabilities of future educational professionals

Med intensjon om å utvikle et pedagogisk redskap for læring og undervisning ble obligatoriske nasjonale prøver innført i skriving, regning, engelsk og matematikk i 2004 (Utdannings- og forskningsdepartementet, 2003). De nasjonale prøvene i skriving fikk kort levetid og ble ikke videreført etter et opphold i 2006, slik som de øvrige nasjonale prøvene. Årsaken var blant annet at det var for lav grad av samsvar, og dermed lav pålitelighet i læreres vurderinger av nasjonale prøver i skriving (Lie, Hopfenbeck, Ibsen, & Turmo, 2003). I et forsøk på å utvikle en ny tilnærming til nasjonale skriveprøver, fikk Skrivesenteret (ved NTNU) i 2010 i oppdrag fra Utdanningsdirektoratet å utvikle nasjonale utvalgsprøver som årlig blir gjennomført av et representativt utvalg elever på 5. og 8. trinn. I tillegg ble det etablert et nasjonalt lærerpanel som skulle vurdere utvalgsprøvene, med den hensikt at et profesjonelt tolkningsfellesskap ville gi større grad av enighet og mer pålitelige vurderinger (Skar & Jølle, 2017). Fra 2017 ble det besluttet å ikke produsere ytterligere utvalgsprøver i skriving. Beslutningen ble tatt av Utdanningsdirektoratet som argumenterte med at de ønsker å benytte de frivillige prøvene som allerede er produsert før de bevilger midler til å utarbeide nye utvalgsprøver (Kirke-, utdannings- og forskningskomiteen, 2017).

Vurderingskriteriene, som blir benyttet i dette prosjektet, tar utgangspunkt i forventningsnormer som ble etablert i samarbeid med lærere gjennom NORM-prosjektet (Berge et al., 2017). Forskerne i NORM-prosjektet hadde som mål å bidra til å styrke den forskingsbaserte kunnskapen om skriveopplæring og vurdering av skriving i grunnskolen. I forbindelse med prosjektet ble det samlet inn elevtekster fra 3. til 7. trinn. Et representativt utvalg på 5196 tekster er samlet i tekstdatabasen Normkorpuset og er tilgjengelig for allmennheten. Et element ved denne studien har vært å benytte Normkorpuset som utgangspunkt for undervisning om, og forskning på skrivevurdering.

Teoretisk rammeverk

Forskningslitteraturen viser blandede oppfatninger omkring et økende fokus på standardisering av skrivevurdering. Mens noen ser utviklingen som en innsnevring av skriveopplæring og en lite hensiktsmessig formalisering av skriveprosessen (Aasen et al., 2012; Torrance, 2007), peker andre på at det gir lærere større autoritet og lettere tilgang til å dele vurderingserfaringer og mulighet for større deltakelse i elevenes skriveutvikling (Dappen, Isernhagen, & Anderson, 2008). Lærere rapporterer ofte at de mangler tilstrekkelig opplæring i undervisning og vurdering av skriving (Dempsey, PytlikZillig, & Bruning, 2009), til tross for langvarig interesse for arbeidsmåter som kan bidra til forbedring av deres kompetanse på dette området. Et eksempel fra Dappen et al. (2008) viser at lærere som deltok i utvikling og implementering av en systematisk, analytisk skrivevurderingsstrategi, hadde høyere selvtillit og opplevde at de var i bedre stand til å hjelpe elever med å utvikle sine skriveferdigheter.

Det finnes ulike tilnærminger til å øke læreres kompetanse med bakgrunn i deres vurdering av skriving og skriveutvikling. I litteraturen brukes begrepet tolkningsfellesskap for å beskrive hvordan en gruppe har en felles forståelse eller deler normer for hvordan tekster skal vurderes (Berge, 2002; Fish, 1980; Skar & Jølle, 2017). Forskning har vist at et ideelt tolkningsfellesskap, der lærere er enige om kvalitetskriterier ved en tekst, kan være vanskelig å etablere (Elder, Barkhuizen, Knoch, & Von Randow, 2007; Skar & Jølle, 2017).

Til tross for økende interesse i feltet, er det fremdeles behov for å forske på hvordan man bygger kompetanse og integrerer opplæring i skrivevurdering i lærerutdanningen og nærliggende pedagogiske utdanninger. Dette behovet gjenspeiles i rammeverket for utvikling og revidering av læreplaner, hvor det legges vekt på skriving som grunnleggende ferdighet i alle fag, og som forutsetning for livslang læring (Utdanningsdirektoratet, 2017). Om lag 10 prosent av barn i grunnskolen har vansker i ett eller flere fag (Haugen, 2010). For et flertall av disse barna er vanskene knyttet til problemer med lesing og skriving (Grøgaard, Hatlevik, & Markussen, 2004; Haugen, 2010). I mange tilfeller vil disse elevene også ha behov for spesialundervisning. Mens spesialpedagoger tradisjonelt er de profesjonelle som jobber tettest med barn som får spesialundervisning, har økt fokus på tilpasset opplæring og tidlig innsats ført til at spesialpedagoger nå kommer inn på et tidligere tidspunkt. Ofte arbeider spesialpedagoger både avhjelpende og forebyggende, før et eventuelt behov for spesialundervisning er dokumentert (Lundetræ & Gabrielsen, 2017). Vurderingskompetanse på elevers skriveferdigheter er derfor særlig relevant for denne gruppen profesjoner.

Dessverre finnes det lite forskning på innholdet i spesialpedagogiske utdanninger i Norge, og vi har ikke funnet tidligere undersøkelser rettet mot spesialpedagoger eller spesialpedagogikkstudenters kompetanse i å vurdere elevtekster. Dette er en tydelig svakhet i kunnskapsbasen ettersom flere vurderingsstudier understreker hvordan ulike utdanningsbakgrunner og karriereerfaringer fører til forskjellige meninger om hva en verdsetter i vurdering av skriftlig arbeid (Cumming, 1990; Cumming, Kantor, & Powers, 2002; Jølle, 2015). Derfor har vi valgt å se nærmere på spesialpedagogikkutdanningen ved en enkelt institusjon; både for å utforske potensialet for å integrere opplæring i skrivevurdering i en slik studie og samtidig undersøke om opplæring i en spesifikk standardisert tilnærming til skrivevurdering kan påvirke fremtidige spesialpedagogers evne til å vurdere elevtekster. Hensikten med intervensjonen var med andre ord å gi studentene en mer pålitelig tilnærming til vurdering av elevtekster, skape et grunnlag for å overveie gjennomførbarhet av skriveopplæring i spesialpedagogiske utdanninger og å gi studentene større bevissthet omkring de utfordringene og dilemmaene en møter i vurdering av elevtekster.

Mens studier rettet mot skrivevurdering som undervisningstema innen spesialpedagogikkutdanninger er fraværende i forskningslitteratur, finnes det et lite antall studier som har utforsket opplæring i standardiserte skrivevurderingssystemer i lærerutdanninger. De fleste av disse har vært opptatt av studentenes anvendelse av og holdninger til ulike tilnærminger (e.g., DelleBovi, 2012; Simon, 2013). Imidlertid er det få undersøkelser som har målt effekten av opplæring i et gitt vurderingsverktøy. Et unntak er en studie av Dempsey, Pytlik Zillig og Bruning (2009) som evaluerte bruk av et nettbaserte verktøy for å bygge skrivevurderingskompetanse blant 109 lærer- og psykologistudenter. Forskerne anvendte en analytisk tilnærming basert på «the Six Trait Model» (Spandel, 2005) med følgende vurderingsområder: ideer, organisering, forfatterens stemme, ordvalg, setningsflyt og konvensjoner. Deltakerne vurderte skriveprøver fra elever på 4. trinn og fikk tilgang til ulike automatiske tilbakemeldinger, bestående av blant annet ekspertvurderinger og vurderinger av deres medstudenter. De fleste studentene gjennomførte aktivitetene på nettstedet i en arbeidsøkt og intervensjonen varte i gjennomsnitt i kun 40 minutter per deltaker. Likevel viste resultatene økt kunnskap om rubrikken fra pretest til posttest og en signifikant høyere grad av enighet, sammenlignet med ekspertvurderinger (Dempsey et al. 2009).

Pedagogers skrivevurderingskompetanse er av stor betydning for å kunne gi elever informasjon om deres faglige nivå, og hva som skal til for å utvikle seg videre. Tradisjonelt har man skilt mellom ulike former for vurdering, der summativ vurdering, eller vurdering av læring, beskriver det faglige nivået, for eksempel i form av en karakter, mens formativ vurdering, også kjent som vurdering for læring, vektlegger at eleven skal lære på bakgrunn av tilbakemelding (Mitchell, 1992; Scriven, 1967). I nyere tid har dikotomien mellom summativ og formativ vurdering blitt kritisert, ettersom begge formene for vurdering bør ha som hensikt at elever vet hvordan de skal lære videre og at de får informasjon om faglig nivå (Baird, Andrich, Hopfenbeck, & Stobart, 2017; Tveit, 2014; Wiliam, 2011). En tredje tilnærming er vurdering som læring, der elevene får ansvar for å vurdere egne tekster og målet er at man gjennom selvevaluering og refleksjon skaper økt kunnskap og bevissthet om skriving og vurdering (Dann, 2014). I forlengelsen av begrepet vurdering som læring, er dette prosjektets formål å undersøke om man også kan bruke vurdering som utdanning. Altså ønsket vi at studentene skulle få økt innsikt og kunnskap om kompleksiteten i tekstvurdering ved å vurdere tekster. Vi ønsket også å gi studentene to ulike vurderingserfaringer, først uten og så med opplæring om formelle kriterier.

Per i dag er det ingen entydige svar på om det å gi opplæring i formelle vurderingskriterier fører til økt enighet, og dermed økt pålitelighet innen tekstvurdering. Noen studier, som Brown, Glasswell, og Harland (2004) har vist at vurderingstrening fører til økt pålitelighet, mens andre studier (Elder et al., 2007) viser at slik trening har liten effekt. Et vesentlig aspekt ved pålitelighet innen vurderingsforskning kan tilskrives forskjellen mellom såkalte «ovenfra og ned» -tilnærminger eller «nedenfra og opp» - tilnærminger. Med en «nedenfra og opp»-tilnærming der teksten vurderes holistisk, vurderes ikke teksten på forhåndsdefinerte områder, men den får en skår basert på hvordan teksten som helhet oppleves av leseren (Cumming et al., 2002). Studier viser at en «ovenfra og ned»-tilnærming med standardiserte vurderingsformer, også kjent som rubrikker, gir større grad av pålitelighet, og samsvar i vurderinger, enn «nedenfra og opp» -tilnærminger (Barkaoui, 2011; Knoch, 2009; Lumley, 2002).

Problemstilling

Studien har som hensikt å undersøke om det å delta i en kortvarig intervensjon om skrivevurdering kan gi spesialpedagogikkstudenter større grad av samsvar i summativ vurdering, og å utforske ytterligere faktorer som kan ha innflytelse på deres vurderingsevner.

Studien har følgende forskningsspørsmål:

- Er det høyere grad av enighet i spesialpedagogikkstudenters vurderinger av elevtekster etter deltakelse i en intervensjon bestående av undervisning om forventningsnormer og skrivevurdering?

- Er spesialpedagogikkstudenters vurdering av elevtekster mer i tråd med vurderinger til erfarne lærere etter å ha deltatt i intervensjonen?

- Hva kjennetegner gode skriveferdigheter ifølge spesialpedagogikk-studenter?

Metode

Studien ble gjennomført etter et pre-test, post-test design der deltakere var spesialpedagogikkstudenter ved Universitetet i Agder. Studentene vurderte elevtekster både før og etter en intervensjon bestående av undervisning og gruppearbeid med fokus på forventningsnormer for skrivevurdering. Hensikten med intervensjonen var å øke studentenes kunnskap og ferdigheter innenfor skrivevurdering under antakelsen at en eventuell økning vil kunne gjenspeiles i en høyere grad av enighet om deres vurderinger av elevtekster på tvers av studentgruppen (spørsmål 1). Videre var det et mål å undersøke om studentenes vurderinger var i tråd med erfarne læreres vurderinger av de samme tekstene, og om eventuelle forskjeller ble redusert gjennom intervensjonen (spørsmål 2). Til slutt var vi interessert i å utforske faktorer som kunne ha innflytelse på deres utvikling av kompetanse på skrivevurdering og oppfatninger om viktige skriveferdigheter (spørsmål 3).

Utvalg

Førti studenter fordelt på et semesterprogram i spesialpedagogikk integrert i lærerutdanningen (13) og et bachelorprogram i spesialpedagogikk (27) deltok i studien. Utvalget besto av 4 menn og 36 kvinner der 20% var 20 år eller yngre, 60% mellom 21 og 30 år, 12,5% mellom 31 og 40 år og 7,5% mellom 41 og 55 år. En femtedel (8) av studentene hadde arbeidet som lærere i skolen og tok spesialpedagogikk som videreutdanning. En fjerdedel (10) hadde erfaring med arbeid i skolen, men uten formell undervisningskompetanse. Over halvparten (55%, 22 studenter) hadde ikke jobbet i skolen. Før intervensjonen vurderte studentene sin egen erfaring med skrivevurdering på en skala fra 1-5 (1 = ingen erfaring, 5 = veldig mye erfaring). Mens 26 av studentene (65%) oppga at de ikke hadde erfaring med skrivevurdering, rapporterte 9 studenter (22,5%) at de hadde lite erfaring og 5 studenter (12,5%) at de hadde kun noe erfaring. Ingen av deltagerne oppga å ha mye, eller veldig mye erfaring med å vurdere skriving.

Intervensjon

Intervensjonen inneholdt en 3-timers forelesning om hva som kan forventes av skriveferdigheter for elever på ulike alderstrinn (forventningsnormer), formativ og summativ vurdering og 3 x 3 timer med seminarer der studentene fikk mulighet til å øve på tekstvurdering. Tekstene som ble brukt i undervisningen og til tekstvurdering er . Korpuset er en digital samling av 5196 elevtekster hentet inn i forbindelse med forskningsprosjektet «Developing national standards for writing. A tool for teaching and learning» også kalt «NORM-prosjektet» (Berge et al., 2017).

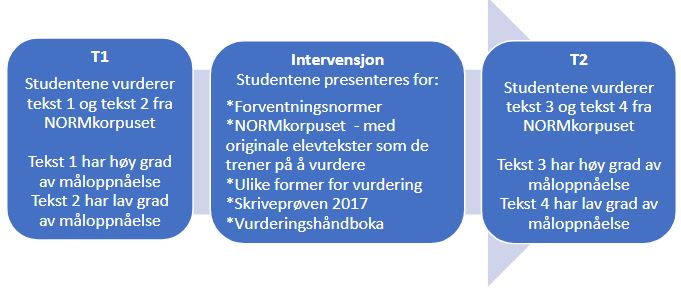

Studentene vurderte 4 tekster skrevet av elever på 4. trinn. Alle studentene vurderte de samme fire tekstene. Vurderingene ble gjennomført på to tidspunkt, før (T1) og etter (T2) undervisning om vurderingskriterier (intervensjonen, se figur 1). På tidspunkt 1 var det 52 studenter som vurderte elevtekster, men grunnet frafall til tidspunkt 2 ble 12 studenter som ikke vurderte tekster på T2 fjernet fra studien. På hvert tidspunkt vurderte studentene én tekst med høy grad av måloppnåelse og én tekst med lav grad av måloppnåelse. Alle tekstene hadde tidligere blitt vurdert av to lærere i forbindelse med NORM-prosjektet (ibid.) og det var med utgangspunkt i disse vurderingen at tekstene hadde blitt definert etter grad av måloppnåelse.

Under intervensjonen hadde studentene en forelesning (med varighet på 3 x 45 minutter) om innholdet i vurderingsområdene, forventningsnormer for ulike klassetrinn og ulike former for tilbakemelding. I løpet av tre seminarer (av 3 x 45 minutter) fikk de opplæring i hvordan de kunne navigere i Normkorpuset for å få tilgang til elevtekster fra ulike klassetrinn. De fikk også en kort gjennomgang av Skriveprøven 2017 og vurderingshåndboken (Nasjonalt senter for skriveopplæring og skriveforskning, 2017), og mulighet til å trene på å vurdere ulike tekster med skalaen og vurderingsområdene fra NORM-prosjektet (Berge et al., 2017). Det ble lagt vekt på at studentene skulle vurdere tekstene individuelt. De skulle ikke diskutere seg frem til enighet om hvordan tekstene skulle vurderes. Likevel hadde de mulighet til å diskutere hva vurderingsområdene kunne inneholde på T1 og innholdet i forventningsnormene og vurderingsområdene på T2.

Datainnsamling og instrumenter

Tekstene ble vurdert på områder som er valgt ut i Normprosjektet (Berge et al., 2017): skriver-leser-interaksjon, innhold, tekstoppbygging, språkbruk og ortografi. På hvert område ble tekstene rangert på en skala fra 1-5 der 1 er lav grad av måloppnåelse, 5 er høy, og 3 er det som kan forventes at en elev bør kunne på det aktuelle klassetrinnet. De fem vurderingsområdene ble kort presentert for studentene før intervensjonen. De hadde dermed kjennskap til kategoriene, men hadde ikke fått undervisning om det teoretiske rammeverket med forventningsnormer og vurderingsområder (ibid.). Områdene blir beskrevet som følger i Vurderingshåndbok for Skriveprøven 2017 utgitt av Nasjonalt Senter for Skriveopplæring og Skriveforskning (2017).

Skriver-leser-interaksjon - Hvordan man henvender seg til en tenkt leser og tar hensyn til denne leserens behov for informasjon.

Innhold - Om innholdet er relevant for oppgaven, og i hvilken grad innholdet er utdypet og vektet på en formålstjenlig måte.

Tekstoppbygging - I hvilken grad teksten er bygd opp på en logisk måte med tanke på kommunikasjonssituasjonen.

Språkbruk - Setningsvariasjon, språklig presisjon, språklige virkemidler.

Formverk, rettskriving, tegnsetting - Her skal du vurdere formalia, det vil si formverk, rettskriving og tegnsetting.

I tillegg til tekstvurderinger, besvarte studentene en spørreundersøkelse ved første datainnsamling (T1). Spørreundersøkelsen besto, blant annet, av spørsmål om informantenes erfaring med vurderingsarbeid, erfaring med arbeid i skolen, alder og andre demografiske opplysninger. For å besvare forskningsspørsmål 3 inkluderte vi en rekke spørsmål der studentene ble bedt om å velge ut hvilke av de fem områdene de mente var lettest, vanskeligst og viktigst å vurdere. Videre ble deltakerne bedt om å oppgi hvor sikre de følte seg med hensyn til skrivevurdering i hvert område på en skala fra 1-5 (1 = veldig usikker, 5 = helt sikker). Spørreskjemaet inneholdt også et åpent spørsmål for å samle inn studentenes perspektiver på hva som kjennetegner gode skriveferdigheter (forskningsspørsmål 3). Studentene svarte på spørreskjemaet og leverte tekstvurderinger via et digitalt innsamlingsverktøy. Studentene fikk informasjon ved studiens oppstart om at deltakelse var frivillig, deres besvarelser var anonyme og samtykke ble gitt ved å gjennomføre den digitale spørreundersøkelsen.

Analyse

Med studiens første forskningsspørsmål var vi interessert i å måle effekten av å gi spesialpedagogikkstudenter undervisning og trening i å bruke felles vurderingskriterier. I en typisk pretest-posttest design er man ofte opptatt av endringer i gjennomsnittsprestasjon på ett eller flere områder. I denne analysen var endring i utvalgets gjennomsnittlige vurderinger ikke hovedinteressen. Det var først og fremst en reduksjon i variasjon (eller en økning i enighet) mellom de 40 studentenes ulike vurderinger som er foreslått å kunne gjenspeile en forbedring i deltakernes vurderingsevner. I analysen har vi valgt den første av disse (operasjonalisert som statistisk varians) ettersom det tillater analyser av variabler bestående av kun en enkelt «skår» i hvert område (f.eks., en students vurdering av dårlig språkbruk måles kun med tallet «1» på skalaen, ikke ved å slå sammen flere underliggende målepunkter). Vi brukte Pitman-Morgans t-test for å teste om forskjellene i varians mellom T1 og T2 var signifikante. Testen brukes ofte i litteraturen for å vurdere homogenitet av varians når variansene er korrelerte (Gardner, 2001), for eksempel i en pretest-posttest design. Testen kan sammenlignes med Levenes test av uavhengige grupper. Cronbachs alfa ble også regnet ut for å sammenligne intern konsistens på tvers av de fem vurderingsområdene ved T1 og T2.

Vi brukte data fra Normprosjektet for å velge ut elevtekster som viste lav og høy grad av måloppnåelse. Disse tekstene var tidligere vurdert av to lærere som hadde fått opplæring i vurderingsnormene og prosjektets teoretiske rammeverk (Berge et al., 2017). Lærernes vurderinger av de fire elevtekstene viste seg å være relativt godt korrelert (Pearsons r = ,67; p < ,001). For å kunne sammenligne studentenes vurderinger med lærernes vurderinger brukte vi en ensidig t-test der testverdien var gjennomsnittene for de to lærernes vurderinger. På denne måten fungerte lærernes vurderinger som en form for hypotetisk idealvurdering. Dersom resultatene viste signifikante forskjeller mellom studenter og læreres vurderinger ved T1, og ingen forskjeller ved T2, ville det være en indikasjon på at intervensjonen hadde en effekt (det vil si at studentenes gjennomsnittlige vurderinger ble mer i tråd med «ekspertenes» vurderinger).

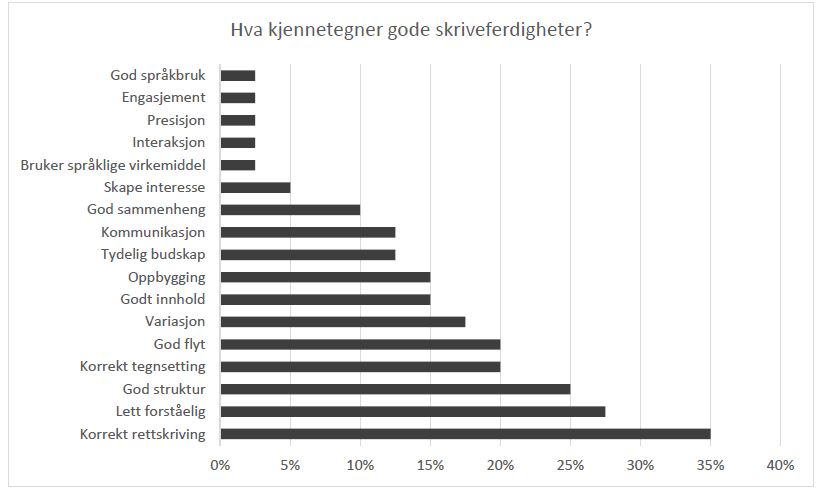

For å besvare forskningsspørsmål 3 tok vi utgangspunkt i studentenes skriftlige svar på spørsmålet «Hva kjennetegner gode skriveferdigheter?». Svarene ble samlet under ulike kategorier og analysert via en innholdsanalytisk tilnærming. Denne tilnærmingen har røtter i en positivistisk forskningstradisjon, der kvantifisering av kvalitativt datamateriale brukes til å representere utbredelsen av beskrivende kategorier (Lincoln & Guba, 1990, s. 336). Vi har rapportert prosentandel av studenter som fremhever ulike områder (i.e., kjennetegn ved gode skriveferdigheter), og har presentert dataene grafisk.

Resultater

Sammenligning av varians fra T1 til T2

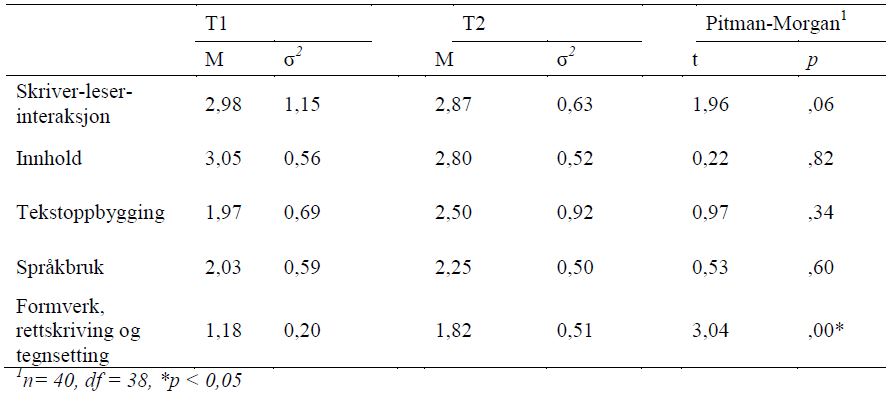

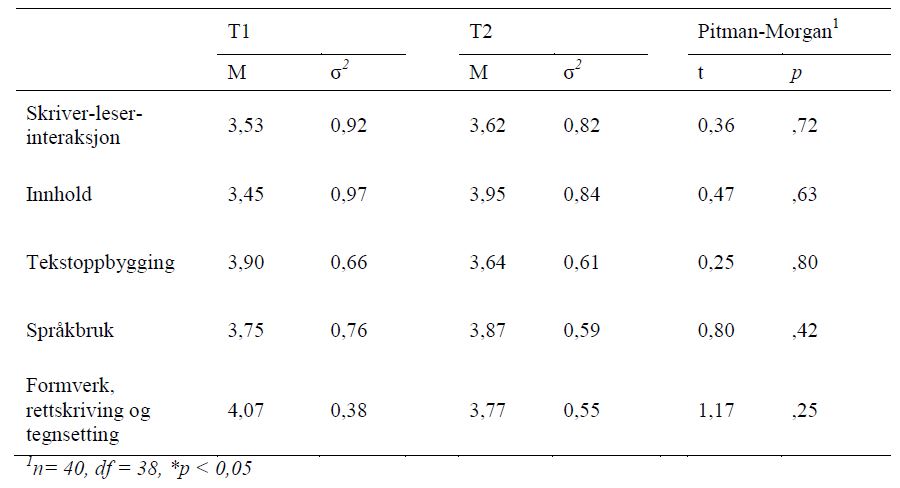

Resultater for Pitman-Morgans test for korrelerte grupper viste ingen signifikante endringer i variansen av studentenes vurderinger fra første (T1) til andre (T2) datainnsamling. Dette gjelder alle fem områdene for tekstene med både høy og lav grad av måloppnåelse (9 analyser). Unntaket var for vurderingen av teksten med lav grad av måloppnåelse i området «formverk, rettskriving og tegnsetting.» I dette tilfellet viste analysen faktisk en signifikant økning i variansen mellom T1 og T2. Mellom tekstene med lav grad av måloppnåelse var det en observerbar forskjell mellom T1 og T2 der variansen minket etter intervensjonen og resultatet var nær signifikant (p = ,06). Resultater av Pitman-Morgan testene presenteres i Tabell 1 og Tabell 2.

I vurdering av intern konsistens (Cronbachs alfa) mellom de fem områdene under T1 og T2 ble det heller ikke funnet tydelige forskjeller. For teksten knyttet til lav grad av måloppnåelse var Cronbachs alfa 0,68 ved T1 og 0,65 ved T2. Forholdsvis økte alfaverdien fra 0,62 til 0,78 etter intervensjonen når det gjaldt elevteksten som var representativ for høy måloppnåelse.

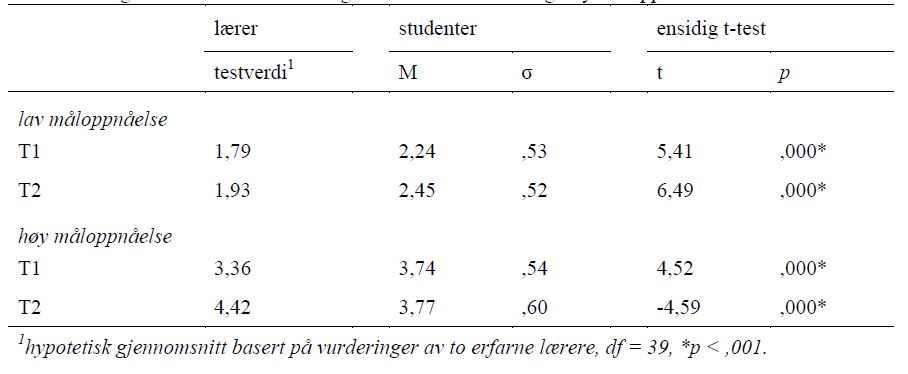

Sammenligning av læreres og studenters vurderinger

I tabell 3 presenteres ensidige t-test resultater for sammenligning av studentenes helhetlige vurderinger av de fire elevtekstene med hypotetiske «forventede» gjennomsnitt basert på to erfarne læreres vurderinger av de samme tekstene (Skar, Thygesen, & Evensen, 2017). Resultatene viser at studentene vurderte tekstene med lav grad av måloppnåelse signifikant høyere enn lærerne både før (gjennomsnittlig forskjell = 0,45) og etter (0,52) intervensjonen. Studentene vurderte tekstene med høy grad av måloppnåelse høyere enn lærerne gjorde før intervensjonen, men lavere enn lærerne etter de hadde fått opplæring om skrivevurdering (gjennomsnittlig forskjell = henholdsvis 0,38 og 0,65).

Studenters prioriteringer

På spørsmål om hvilket område studentene mente det var viktigst å vurdere var det to områder som utmerket seg: (a) formverk, rettskriving og tegnsetting (32,5%, 13 studenter) og (b) innhold (30%, 12 studenter). Kun to deltakere (5%) oppga tekstoppbygging som det viktigste området, mens skriver-leser-interaksjon og språkbruk ble regnet som det viktigste av henholdsvis 7 (17,5%) og 6 (15%) studenter.

Som et åpent spørsmål ble studentene bedt om å beskrive hva som kjennetegner gode skriveferdigheter. Studentenes svar er samlet i Figur 2.

Områdene som ble valgt ut i Normprosjektet ble også oppgitt som kjennetegn på gode skriveferdigheter av studentene i denne studien. Formverk, rettskriving og tegnsetting ble skrevet av 35% (rettskriving) og 20% (tegnsetting) av studentene. Skriver-leser-interaksjon omhandler hvordan man henvender seg til en tenkt leser og ble oppgitt i form av at teksten skal være lett forståelig (28%), kommunisere godt (13%), ha et tydelig budskap (13%) og god interaksjon (3 %). Godt innhold og tekstoppbygging ble trukket frem av 15% av deltagerne, mens god språkbruk ble oppgitt av 3%. I tillegg til disse områdene kom det frem kjennetegn ved gode skriveferdigheter som ikke er direkte representert i tittelen på vurderingsområdene fra Normprosjektet. Eksempler på dette er god flyt (20%), variasjon (18%), å ha et tydelig budskap (13 %), skape interesse (5%) og engasjement (3%).

Diskusjon

Ble studentene likere i sine vurderinger med felles kriterier?

Målet med studien var å undersøke om det å delta i en kortvarig intervensjon om skrivevurdering kan gi spesialpedagogikkstudenter større grad av samsvar i summativ vurdering, og å utforske ytterligere faktorer som kan ha innflytelse på deres vurderingsevner. Med det første forskningsspørsmålet undersøkte vi om det å delta i en kortvarig intervensjon om skrivevurdering førte til større grad av enighet om summativ vurdering. For å undersøke dette ble det målt statistisk varians mellom vurderinger på to tidspunkt, et før og et etter intervensjonen. En reduksjon i varians fra T1 til T2 kunne tolkes som at studentenes vurderinger ble likere. Resultat av studien viste derimot ingen betydelig endring mellom de to tidspunktene. Det kan være ulike årsaker til dette. Intervensjonens lengde var i denne studien begrenset. Tilsvarende studier, som erfaringene fra Normprosjektet (Skar et al., 2017) viser at det tar tid å implementere systemer for vurdering og skape tolkningsfellesskap. At studentene kun fikk 12 timer med undervisning, implementering og vurderingspraksis, kan ha bidratt til at det ikke ble målt effekt av intervensjonen. Samtidig er det viktig å påpeke at det er begrensede tidsressurser til ulike temaer innen en profesjonsutdanning. I dette prosjektet tok vi utgangspunkt i hva det var realistisk å gjennomføre som en del av et semesteremne i spesialpedagogikk.

En annen årsak kan være knyttet til betingelser ved pretesten. For å kunne sammenligne vurderingene på T1 og T2 fikk studenten oppgitt vurderingsområdene før intervensjonen. De kjente ikke til innholdet i vurderingsområdene, som var en del av intervensjonen, men de fikk oppgitt tittelen på hvert område (skriver-leser-interaksjon, innhold, tekstoppbygging, språkbruk og tegnsetting, rettskriving og formverk). Kombinert med at hvert område skulle vurderes på en skala fra 1-5, kan dette ha bidratt til lav grad av variasjon på T1. Dette kan illustreres ved å se på vurderingen av teksten med lav grad av måloppnåelse på området «formverk, rettskriving og tegnsetting» på T1, der 85% av studentene var enige om at eleven viste meget lav grad av mestring (karakter 1 på en fempunktsskala). En relativt høy grad av enighet finnes på samme område for teksten som representerer høy grad av mestring. Her oppgir 62,5 % av studentene at eleven viste høy grad av mestring (karakter 4) ved T1.

En utfordring ved å måle effekt av intervensjonen ble dermed at det settes høye krav til å øke grad av enighet på T2 ettersom de som vurderer allerede er, i hvert fall på noen områder, svært enige på T1. Dette kan bety at det oppstår et tak, der det skal mye til å bli mer enige. Årsaken til at intervensjonen ikke hadde effekt kan dermed være at studentene fikk for mye informasjon om vurderingsområdene, og for liten grad av valgfrihet med en fempunktsskala til å skape rom for variasjon i vurderingene på T1.

Forskjeller mellom lærere og studenter

Et hypotetisk «gjennomsnittsideal» ble beregnet basert på vurderinger gjennomført av to lærere med tidligere opplæring i Normprosjektets vurderingsområder, og lang erfaring med skrivevurdering (Skar et al., 2017). Analysen viste en signifikant forskjell mellom studentenes gjennomsnittlige vurderinger og lærernes vurderinger både før og etter intervensjonen. At studentenes helhetlige vurderinger er forskjellige fra lærernes er kanskje ikke overaskende gitt studentenes begrensede erfaring med skrivevurderinger og arbeid i skolen. Imidlertid er dette i tråd med funnet om at variasjonen i studentenes vurderinger ikke ble redusert ved å delta i en intervensjon rettet mot forbedring av deres vurderingskompetanse. Med andre ord viser funnene at studentene hverken ble mer enige med hverandre etter intervensjonen, eller mer enige sammenlignet med en "eksperts" vurdering av de samme tekstene.

Det kan stilles spørsmål ved om lærere med lang erfaring innen vurdering kan regnes som «eksperter» studentene skal måles opp mot. Premisset for denne hypotesen ligger i teorien om at man gjennom implementering av standardiserte vurderingskriterier skapt i et profesjonelt tolkningsfelleskap, kan øke påliteligheten i vurdering (Brown et al., 2004). Pålitelighetsstudier av tekstvurdering viser (som beskrevet i teoretisk rammeverk) at det også blant lærere med lang erfaring med tekstvurdering kan være relativt lav grad av enighet om summativ vurdering (Lie et al., 2003; Skar & Jølle, 2017). De to lærerne som er «eksperter» i denne studien, var to av 40 lærere som deltok i studien til Skar og kolleger (2017) der påliteligheten gikk ned etter innføring av felles vurderingskriterier. Argumentet fra Skar et al. (2017) er at det tar tid å implementere nye verktøy for vurdering, og i en periode før disse verktøyene er tilstrekkelig integrert som en del av læreres (eller studenters) vurderingsferdigheter, kan man oppleve en negativ utvikling der vurderingene blir mer ulike. En implikasjon er dermed at en intervensjon der man skal undersøke effekt av å innføre felles vurderingskriterier, bør ha et større omfang enn det som var tilfellet i denne studien. Disse erfaringene vil det være relevant å ta med til videre studier og undervisning om pålitelighet innen skrivevurdering.

Hva legger studentene vekt på i vurderingen?

For å besvare det tredje forskningsspørsmålet, «hvilke ferdigheter legger spesialpedagogikkstudenter vekt på i vurdering av elevtekster», ble det valgt både en kvantitativ og en kvalitativ tilnærming. I den kvantitative tilnærmingen ble deltagerne bedt om å velge hvilket av de fem vurderingsområdene fra Normprosjektet (Berge et al., 2017) de mente det var viktigst å vurdere. To områder utmerket seg, «formverk, rettskriving og tegnsetting» (32,5%) og «innhold» (30%). For å undersøke om studentene ville valgt de samme områdene dersom de ikke var begrenset til fem forhåndsdefinerte områder fikk de i et åpent spørsmål om hva de hevdet kjennetegnet gode skriveferdigheter.

I tillegg til områdene som ble valgt med utgangspunkt i NORM-prosjektet (ibid.), oppga studentene områder som variasjon, å ha et tydelig budskap, skape interesse og skape engasjement. Noen av deltagerne oppga flere områder og beskrev hvordan gode skriveferdigheter vil være å inneha ulike former for kompetanse. For eksempel beskriver en student gode skriveferdigheter, i form av kjennetegn ved en god tekst, på følgende måte:

En god tekst skal ha god oppbygging, bruke riktig tegnsetning, og skape interesse hos leseren. Gjentakelser kan være bra, om det brukes på riktig måte som et virkemiddel. Det bør være et rikt og variert språk med god flyt.

Dette viser at studentene vektlegger en rekke områder når de vurderer hva som er en god tekst. Det kan dermed være en begrensning ved fem forhåndsdefinerte vurderingsområder at den som skal vurdere ikke har mulighet til å vurdere teksten med flere kategorier. En slik begrensning kan påvirke i hvor stor grad vurderere er enig om karaktersetting på de ulike områdene. En kan tenke seg to mulige utfall av å kunne vurdere tekster med flere vurderingsområder. (1) Flere vurderingsområder skaper mulighet for større varians fordi det er flere områder der vurderingen kan være ulik. (2) Flere vurderingsområder kan skape lavere varians fordi den som vurderer kan være mer presis. For å illustrere kan man ta utgangspunkt i kategorien språkbruk. En som vurderer språkbruk kan ut ifra områdets innholdsbeskrivelse legge stor vekt på setningsvariasjon, og gi en tekst med høy grad av variasjon, men lav grad av presisjon en høy karakter. Den samme teksten kan vurderes av en annen som vektlegger språklig presisjon. Den vil gi område «språkbruk» en lav karakter. Dersom de to områdene ble delt inn i to kategorier (variasjon og presisjon), i stedet for èn (språkbruk), ville man trolig fått større grad av enighet mellom de to som skulle vurdere teksten. Implikasjonen vil dermed være at for få kategorier kan være en begrensning som skaper lav grad av enighet mellom vurderere. I tillegg er det rimelig å forvente at god pålitelighet er lettere å oppnå i noen svært begrensede områder fremfor andre mer sammensatte og komplekse områder. Vi foreslår at fremtidig forskning rettes mot å isolere de områdene der høy pålitelighet er lettest å oppnå.

Begrensinger

Det er flere begrensinger med studien som er viktige å påpeke. Blant annet bygger studien på et kvasieksperimentelt design, uten en kontrollgruppe. I ettertid er mangel på kontrollgruppe mindre problematisk gitt at studiens resultater ikke viser tydelig effekt av intervensjonen. Likevel er det mulig at implementerings- eller systemrelaterte faktorer kan ha påvirket deltakeres utbytte av opplæringen, og at disse ville ha vært lettere å oppdage dersom en kontrollgruppe var inkludert i studien.

Ytterligere begrensinger som bør tas i betraktning er at studiens utvalg er relativt lite og ikke tilfeldig valgt. Disse forholdene, samt en synlig variasjon i utvalgets sammensetting (i.e, variert arbeidserfaring, programtilhørighet, alder osv.), gjør at tolkning av studiens funn må gjøres med forsiktighet, særlig med hensyn til generalisering av funnene til andre kontekster eller studentgrupper. På grunn av utvalgets begrensede omfang var det dessverre ikke rimelig å skille ut ulike undergrupper.

Implikasjoner for fagfeltet og videre forskning

I denne studien ønsket vi å undersøke om studentene ble likere i sine vurderinger. I ettertid har vi erfart at det også ville vært interessant å samle data om vurdereres holdninger til og meninger om skrivevurderingen før og etter en slik intervensjon. Dette ville vært i tråd med Danns (2014) forståelse av «vurdering som læring», der elever opplever økt kunnskap om vurdering gjennom å vurdere egne tekster. I motsetning til Danns (2014) forståelse vil hensikten her være at studenter får økt kunnskap om kompleksiteten ved vurdering ved å delta i en intervensjonsstudie. Ved å introdusere studenter for tekstkorpora der de selv kan finne tekster fra elever på ulike trinn, og praktisere vurdering, opplevde vi at studentene fikk større innsikt i dilemmaer ved vurderingsdidaktikk. På kort sikt kan denne kunnskapen ha ført til mer usikkerhet om egen vurderingsevne (se drøfting om årsaker til at vurderingene ble mer ulike), men på lenger sikt kan det ha en annen effekt. Dermed ville det vært relevant å gjennomføre en longitudinell studie for å undersøke hvordan synet på egen vurderingsevne utvikler seg over tid.

Det er flere andre faktorer som kan forbedres i fremtidig forskning, hvorav noen er drøftet ovenfor (f.eks., intervensjonens omfang). Vi mener at læreres vurderinger av elevers skriveferdigheter må være mer pålitelig en dagens evidens tilsier (Skar et al., 2017). Dersom dagens situasjon skal forbedres krever det mer robust forskning av høy kvalitet.

Konklusjon

I studien var hensikten å undersøke om opplæring i bruk av standardiserte vurderingsformer kan bidra til å heve vurderingskompetansen og påliteligheten i studenters vurderinger av elevtekster. En reduksjon i varians fra vurderinger gjennomført før og etter opplæring om standardiserte vurderingsformer kan tolkes som at studentenes vurderinger ble likere. Imidlertid fant vi ingen betydelige endringer. Det kan være ulike årsaker til dette, som (a) begrenset lengde og intensitet av intervensjonen, (b) at betingelser ved pretesten ga nok informasjon til å øke vurderingens pålitelighet til stor grad av enighet mellom deltakerne på T1, (c) fem vurderingsområder med en fempunktskala kan være for lite nyansert for å fange opp små endringer i vurdering. Tidligere forskning viser at «ovenfra og ned» - tilnærminger gir en høyere grad av pålitelighet enn «nedenfra og opp» - strategier (Barkaoui, 2011; Knoch, 2009; Lumley, 2002). Ettersom funnene våre ikke viser endringer etter intervensjonen er det naturlig å stille spørsmålstegn ved om intervensjonens omfang var tilstrekkelig. Studien bidrar dermed til feltet ved å illustrere et behov for langvarig og intensiv opplæring når formålet er å øke pålitelighet blant studenter. Samtidig vil det være viktig å ta i betraktning hva som faktisk er realistisk å gjennomføre innen et semesteremne i spesialpedagogikk.

Studiens funn viser at det er vanskelig å finne pålitelige vurderingsformer for elevtekster, og øke grad av enighet mellom vurderere gjennom opplæring i felles vurderingskriterier. Fra et utdanningsperspektiv mener vi likevel at opplæring i skrivevurdering hadde en egenverdi ettersom fremtidige pedagoger fikk mulighet til å få et innblikk i kompleksiteten ved tekstvurdering. Denne kunnskapen fikk studentene uavhengig av grad av konsensus etter implementering av standardiserte vurderingskriterier. I et bredere forskningsperspektiv er det nødvendig å undersøke hvordan en kan øke pålitelighet for tekstvurdering og finne didaktiske tilnærminger for å forbedre vurderingsevner blant studenter innen spesialpedagogikk og andre profesjonspedagogiske utdanninger.

Vi vil rette en stor takk til Normprosjektgruppen som ga oss tilgang til deres datamateriale, og til Avdeling for lærerutdanningen ved Universitetet i Agder for finansiering av vårt forskningsprosjekt.

Litteraturhenvisninger

Aasen, P., J., Møller, E. Rye, E. Ottesen, T.S. Prøitz og F. Hertzberg (2012). Kunnskapsløftet som styringsreform–et løft eller et løfte? Forvaltningsnivåenes og institusjonenes rolle i implementeringen av reformen. NIFU Report 20/2012. Oslo: NIFU.

Baird, J.-A., Andrich, D., Hopfenbeck, T. N., & Stobart, G. (2017). Assessment and learning: Fields apart? Assessment in Education: Principles, Policy & Practice, 24(3), 317-350.

Barkaoui, K. (2011). Think-aloud protocols in research on essay rating: An empirical study of their veridicality and reactivity. Language Testing, 28(1), 51-75.

Berge, K. L. (2002). Hidden Norms in Assessment of Students’ Exam Essays in Norwegian Upper Secondary Schools. Written Communication, 19(4), 458–492. doi: http://doi.org/10.1177/074108802238011

Berge, K. L., Skar, G. B., Matre, S., Solheim, R., Evensen, L. S., Otnes, H., & Thygesen, R. (2017). Introducing teachers to new semiotic tools for writing instruction and writing assessment: consequences for students’ writing proficiency. Assessment in Education: Principles, Policy & Practice, 1-20.

Brown, G. T., Glasswell, K., & Harland, D. (2004). Accuracy in the scoring of writing: Studies of reliability and validity using a New Zealand writing assessment system. Assessing writing, 9(2), 105-121.

Cumming, A. (1990). Expertise in evaluating second language compositions. Language Testing, 7(1), 31-51.

Cumming, A., Kantor, R., & Powers, D. E. (2002). Decision making while rating ESL/EFL writing tasks: A descriptive framework. The Modern Language Journal, 86(1), 67-96.

Dann, R. (2014). Assessment as learning: blurring the boundaries of assessment and learning for theory, policy and practice. Assessment in Education: Principles, Policy & Practice, 21(2), 149-166. doi:10.1080/0969594X.2014.898128

Dappen, L., Isernhagen, J., & Anderson, S. (2008). A statewide writing assessment model: Student proficiency and future implications. Assessing writing, 13(1), 45-60.

DelleBovi, B. M. (2012). Literacy instruction: From assignment to assessment. Assessing writing, 17(4), 271-292.

Dempsey, M. S., Pytlik Zillig, L. M., & Bruning, R. H. (2009). Helping preservice teachers learn to assess writing: Practice and feedback in a Web-based environment. Assessing writing, 14(1), 38-61.

Elder, C., Barkhuizen, G., Knoch, U., & Von Randow, J. (2007). Evaluating rater responses to an online training program for L2 writing assessment. Language Testing, 24(1), 37-64.

Fish, S. E. (1980). Is there a text in this class?: The authority of interpretive communities: Harvard University Press.

Grøgaard, J.B., Hatlevik, I. & Markussen, E. (2004). Eleven i fokus? En brukerundersøkelse av norsk Spesialundervisning etter enkelt vedtak. Oslo: NIFU rapport nr. 9.

Haugen, R. (2010). Lærevansker - historikk og begrepsdefinisjoner. In R. H. m. f. (Red.) (Ed.), Barn og unges læringsmiljø 4 (s. 15 - 39). Kristiansand: Høyskoleforlaget.

Jølle, L. (2015). Vurderingsdialogen. En undersøkelse av tekstvurderingspraksis ved nasjonal læringsstøttende prøve i skriving. Doktoravhandling, Norges teknisk-naturvitenskapelige universitet, Trondheim. Hentet fra https://brage.bibsys.no/xmlui/bitstream/handle/11250/298034/Lennart_Jolle.pdf?sequence=3

Kirke-, utdannings- og forskningskomiteen,. (2017). Innstilling fra kirke-, utdannings- og forskningskomiteen om Lærelyst – tidlig innsats og kvalitet i skolen - Meld. St. 21 (2016–2017). Retrieved from https://www.stortinget.no/nn/Saker-og-publikasjonar/publikasjonar/Innstillingar/Stortinget/2016-2017/inns-201617-432s/?all=true

Knoch, U. (2009). Diagnostic Writing Assessment: The Development and Validation of a Rating Scale. Frankfurt am Main: Peter Lang.

Lie, S., Hopfenbeck, T. N., Ibsen, E., & Turmo, A. (2003). Nasjonale prøver på ny prøve: rapport fra en utvalgsundersøkelse for å analysere og vurdere kvaliteten på oppgaver og resultater til nasjonale prøver våren 2005. Acta didactica http://urn. nb. no/URN: NBN: no-14449.

Lincoln, Y. S., & Guba, E. G. (1990). Judging the quality of case study reports. Internation Journal of Qualitative Studies in Education, 3(1), 53-59.

Lumley, T. (2002). Assessment criteria in a large-scale writing test: What do they really mean to the raters? Language Testing, 19(3), 246-276.

Lundetræ, K., & Gabrielsen, E. (2017). Skolens oppfølging av elever som strever med lesing. In E. Gabrielsen (Ed.), Klar framgang! : leseferdighet på 4. og 5. trinn i et femtenårsperspektiv (s. 154 - 165). Oslo: Universitetsforl.

Mitchell, R. (1992). Testing for learning: How new approaches to evaluation can improve American schools: Simon and Schuster.

Nasjonalt senter for skriveopplæring og skriveforskning. (2017). Vurderingshåndbok for Skriveprøven 2017 Retrieved from http://www.skrivesenteret.no/uploads/files/Skriveproven2017/Vurderingshandbok_2017.pdf

Scriven, M.S. (1967). The methodology of evaluation. Perspectives of Curriculum Evaluation, and AERA monograph Series on Curriculum Evaluation, No. 1. Chicago: Rand NcNally.

Simon, R. (2013). "Starting with What Is": Exploring Response and Responsibility to Student Writing through Collaborative Inquiry. English Education, 45(2), 115-146.

Skar, G. B. & Jølle, L. (2017). Teachers as raters: Investigation of a long term writing assessment program. L1 Educational Studies in Language and Literature, 17(Open Issue), 1–30. doi: http://doi.org/10.17239/L1ESLL-2017.17.01.06

Skar, G. B., Thygesen, R., & Evensen, L. S. (2017). Assessment for learning and standards: A Norwegian strategy and its challenges. In Standard Setting in Education (pp. 225-241): Springer.

Spandel, V. (2005). Creating writers; through 6-trait writing assessment and instruction (Vol. 24). Boston, MA: Pearson Education, Inc.

Torrance, H. (2007). Assessment as learning? How the use of explicit learning objectives, assessment criteria and feedback in post-secondary education and training can come to dominate learning. Assessment in Education: Principles, Policy & Practice, 14(3), 281- 294.

Tveit, S. (2014). Educational assessment in Norway. Assessment in Education: Principles, Policy and Practice, 21(2), 221–237.

Utdannings- og forskningsdepartementet. (2003). Nasjonale prøver og gjennomføringen våren 2004. Retrieved from https://www.regjeringen.no/no/dokumenter/nasjonale-prover-og-gjennomforing-varen-/id109339/

Utdanningsdirektoratet. (2017). Rammeverk for grunnleggende ferdigheter. Retrieved from https://www.udir.no/laring-og-trivsel/lareplanverket/grunnleggende-ferdigheter/rammeverk-for-grunnleggende-ferdigheter/

William, D. (2011). What is assessment for learning? Studies in Educational Evaluation, 2011 (37), 3-14.